Вышел Kling O1 — рассуждающая нейросеть для генерации и редактирования видео

Сохраняется 0 В закладки 0 В закладках 0

Kling AI выпустила новую ИИ-модель Kling O1 (Omni One). Это рассуждающая нейросеть, которая генерирует видео по тексту и редактирует уже снятые ролики с помощью простых промтов: можно менять объекты, добавлять элементы, удалять лишнее и полностью менять стиль сцены без пересъёмки и ручных масок.

Модель уже доступна на сайте Kling, а также на платформах, включая Fal AI, VEED, Wavespeed и прочие. Подробности в материале Postium.

Нейросеть Kling O1 — что это и как работает

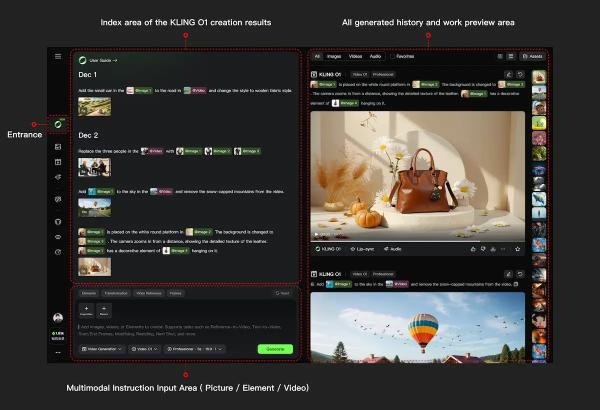

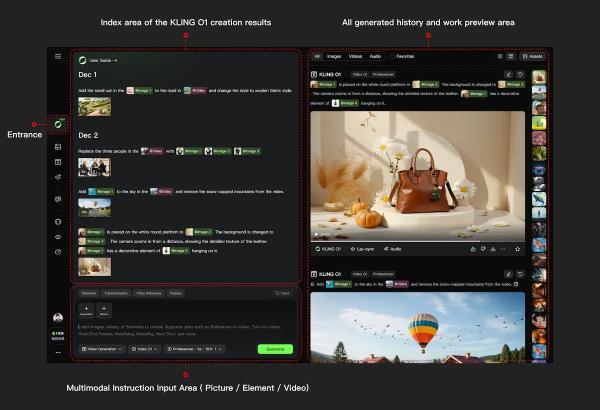

Kling O1 — мультимодальная модель, которая понимает текст, изображения и видео одновременно. Она использует Chain of Thought: сначала разбирает промт на смысловые элементы — что в кадре, как двигается камера, какой свет — и лишь потом создаёт или перерабатывает ролик. Это повышает точность движения, стабильность объектов и соответствие запросу.

В основе лежит Multi-Modal Video Engine — движок, который анализирует исходное видео или кадры, сопоставляет их с описанием и (если нужно) с референсом, а затем встраивает изменения так, чтобы ролик оставался целостным от начала до конца.

У модели три рабочих режима:

- Multi-Elements (video-to-video) — точечное редактирование уже снятого ролика по тексту;

- text-to-video — полноценная генерация по описанию;

- frame mode — построение видео между заданными начальным и финальным кадрами.

Главное отличие от Kling 1.6 — более точное следование промту для генерации видео и стабильность объектов. Персонажи реже «ломаются» между кадрами, камеры двигаются предсказуемее, а движения выглядят естественнее.

Что реально изменилось? Теперь можно текстом менять элементы внутри настоящего видео — заменять предметы, добавлять эффекты, убирать лишние детали или перестилизовывать ролик. Раньше такие задачи требовали пересъёмки или полноценного VFX-цикла.

Кроме того, в генерации O1 лучше удерживает детали и реже уходит в «творческую самодеятельность». Frame mode даёт почти операторский контроль — можно задать кадры «начала» и «конца» и получить видео, которое между ними развивается плавно и в нужной манере.

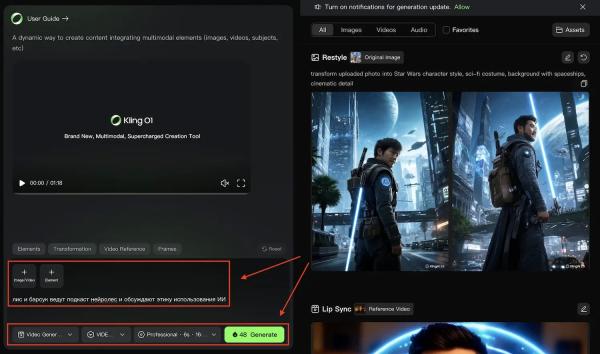

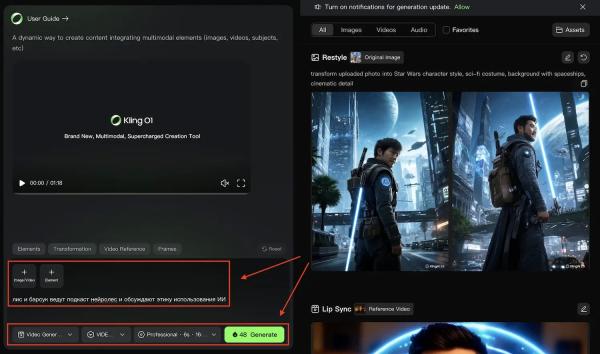

Как пользоваться Kling O1?

Зайдите на сайт Kling (или любую платформу, где доступна нейросеть) и выберите модель Kling O1. В text-to-video пишется подробный промпт с описанием объектов, действий, света и поведения камеры.

В Multi-Elements загружается исходное видео (до 10 секунд) и до 4 картинок, либо до 7 картинок в качестве референса. Дальше в промте указывается, что заменить, что удалить или как изменить стиль.

В frame mode загружаются два изображения, а текстом описывается динамика между ними. Модель сама строит движение и сцену.

Предыдущие модели Kling делали ставку на генерацию коротких роликов по тексту и изображениям, но слабо справлялись с редактированием настоящего видео. Мультимодальность O1 и новый движок расширили эти возможности.

Итог: Kling O1 превращает генератор видео в инструмент постпродакшена: теперь можно править уже снятые ролики по текстовому описанию и обрабатывать материал.

Ранее вышла ИИ-модель для генерации видео HunyuanVideo 1.5.

⭐ Тестим нейросети каждый день, а то, что реально работает — сливаем в Telegram-канал: .

Тэги Kling AI Нейросети