Qwen открыла исходный код Qwen3-TTS — это ИИ для генерация речи с задержкой от 97 мс

Сохраняется 0 В закладки 0 В закладках 0

Команда Qwen объявила об открытии исходного кода и весов всей серии Qwen3-TTS. Это набор моделей для генерации речи, клонирования голоса и «Voice Design» — создания нового тембра по текстовому описанию.

Модели уже доступны в открытом доступе на ModelScope, Hugging Face и GitHub. Также они подключаются через Qwen API для облачного использования.

Нейросеть Qwen3-TTS — что это и что умеет

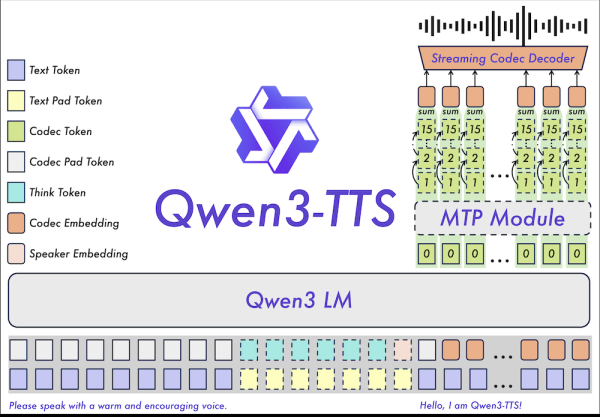

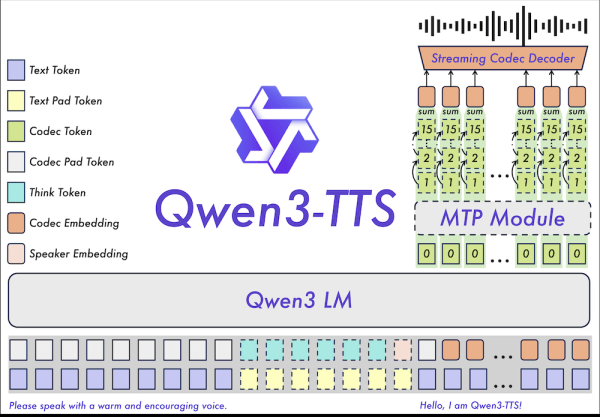

Qwen3-TTS — это стриминговые TTS-модели с архитектурой Dual-Track. Ключевая особенность — сверхнизкая задержка: первый аудиофрагмент может приходить уже после ввода одного символа, а заявленная сквозная задержка начинается от 97 мс.

Линейка построена без DiT-подхода и ориентирована на end-to-end генерацию речи. Модели выпускаются в двух размерах: версия на 1,7 млрд параметров для максимального качества и версия на 0,6 млрд — для более экономичных и быстрых сценариев.

Отдельный акцент сделан на многоязычность. Модели поддерживают 10 языков: китайский, английский, японский, корейский, немецкий, французский, русский, португальский, испанский и итальянский, а также различные диалектные варианты.

Как пользоваться

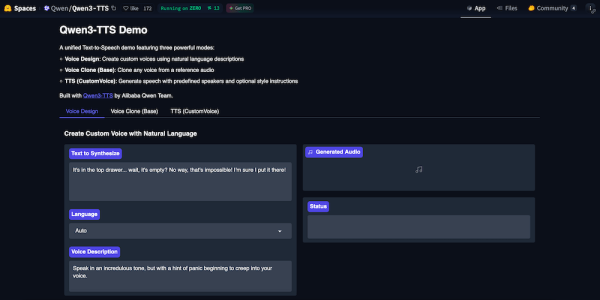

Для быстрого старта доступны онлайн-демо на платформах с моделями. Для локального запуска можно скачать веса и код из репозиториев, например на Hugging Face. Там же доступно демо:

В облаке Qwen3-TTS работает через API с оплатой по количеству входных символов, без необходимости разворачивать инфраструктуру самостоятельно.

Почему это важно? Минимальная задержка делает Qwen3-TTS пригодным для реального диалога — голосовых ассистентов, игр, интерактивных интерфейсов и live-озвучки.

Для рынка это означает появление мощного open-source инструмента, который может конкурировать с закрытыми решениями. Поддержка русского языка «из коробки» и отсутствие привязки к сложной диффузионной архитектуре делают модель привлекательной для создания локальных голосовых помощников и систем озвучки контента.

Таким образом, индустрия ИИ активно движется в сторону мультимодальности и снижения задержек (low latency). Ранее стандартом считалась потоковая передача после генерации предложения или фразы, теперь борьба идет за миллисекунды. Qwen продолжает стратегию открытия своих разработок, следуя тренду, заданному релизами Llama и Mistral, но с фокусом на мультимедийные возможности.

Итог: Разработчики получили бесплатный доступ к быстрой и мультиязычной нейросети для синтеза речи, способной работать практически в реальном времени.

Ранее Google выпустила TranslateGemma — открытые ИИ-модели для перевода.

⭐ Тестим нейросети каждый день, а то, что реально работает — сливаем в Telegram-канал: .

Тэги Qwen Нейросети